LLMS, agentes, herramientas y marcos

La inteligencia synthetic generativa (Genai) está llena de conceptos y términos técnicos; Algunos términos que a menudo encontramos son modelos de idiomas grandes (LLM), agentes de IA y sistemas de agente. Aunque están relacionados, tienen propósitos diferentes (pero relacionados) dentro del ecosistema AI.

Los LLM son los motores lingüísticos fundamentales diseñados para procesar y generar texto (e imágenes en el caso de los multimodelos), mientras que los agentes están destinados a extender las capacidades de LLM al incorporar herramientas y estrategias para abordar problemas complejos de manera efectiva.

Los agentes adecuadamente diseñados y construidos pueden adaptarse en función de la retroalimentación, refinar sus planes y mejorar el rendimiento para tratar de manejar tareas más complicadas. Los sistemas de agente ofrecen ecosistemas más amplios e interconectados que comprenden múltiples agentes que trabajan juntos hacia objetivos complejos.

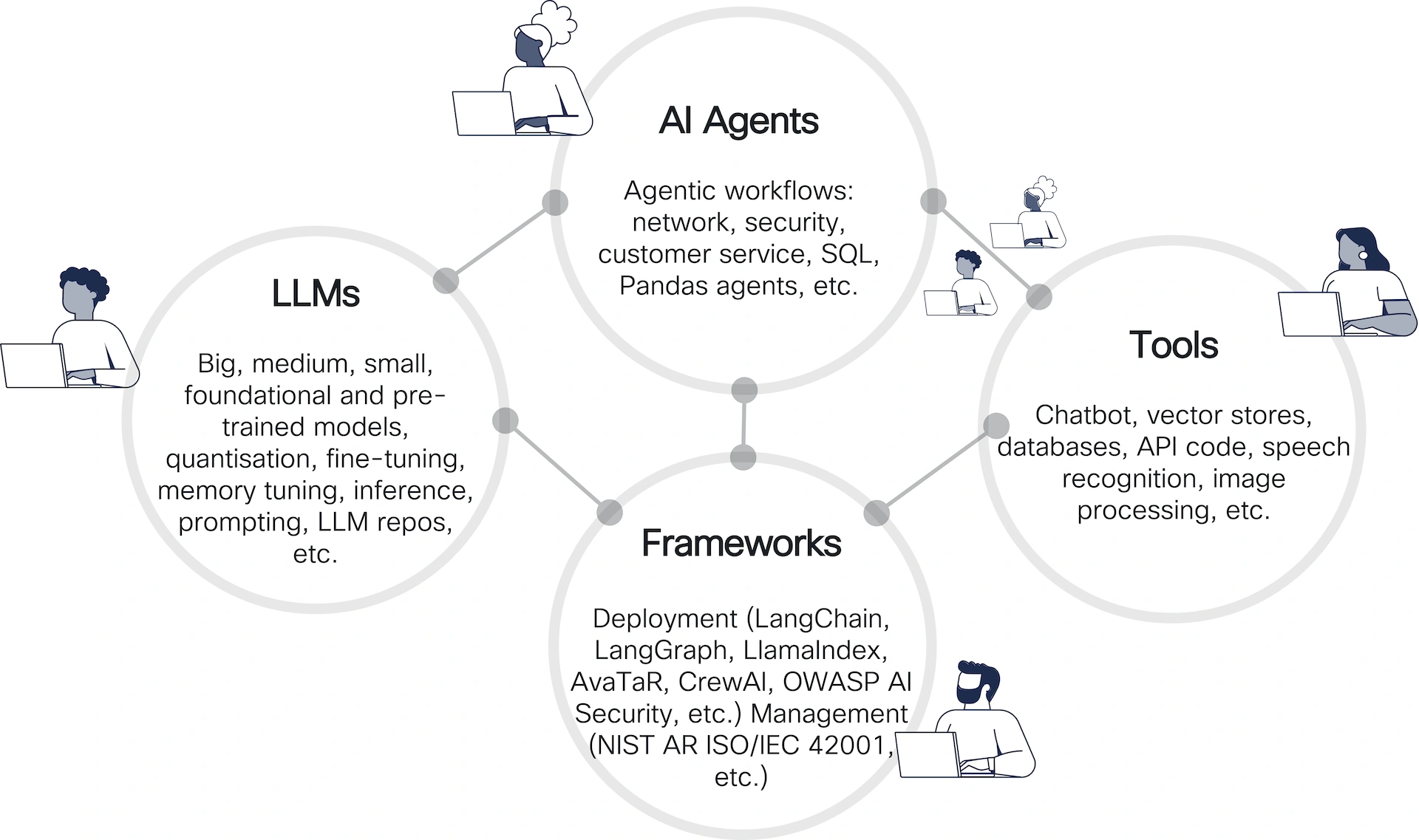

La figura anterior describe el ecosistema de los agentes de IA, que muestra las relaciones entre cuatro componentes principales: LLMS, Agentes de IA, Marcosy Herramientas. Aquí hay un desglose:

- LLMS (modelos de idiomas grandes): Representar modelos de diferentes tamaños y especializaciones (grande, mediano, pequeño).

- Agentes de IA: Construido sobre LLMS, se centran en flujos de trabajo impulsados por agentes. Aprovechan las capacidades de los LLM al tiempo que agregan estrategias de resolución de problemas para diferentes fines, como automatizar tareas de pink y procesos de seguridad (¡y muchos otros!).

- Marcos: Proporcionar soporte de implementación y gestión para aplicaciones de IA. Estos marcos unen la brecha entre LLM y entornos operativos al proporcionar las bibliotecas que permiten el desarrollo de sistemas de agente.

- Los marcos de implementación mencionados incluyen: Langchain, Langgraph, Llamaindex, Avatar, Crewai y OpenAi Swarm.

- Los marcos de gestión se adhieren a estándares como NIST AR ISO/IEC 42001.

- Herramientas: Habilitar la interacción con los sistemas AI y expandir sus capacidades. Las herramientas son cruciales para entregar soluciones a IA a los usuarios. Los ejemplos de herramientas incluyen:

- Chatbots

- Tiendas vectoriales para la indexación de datos

- Bases de datos e integración de API

- Reconocimiento de voz y utilidades de procesamiento de imágenes

AI para el equipo rojo

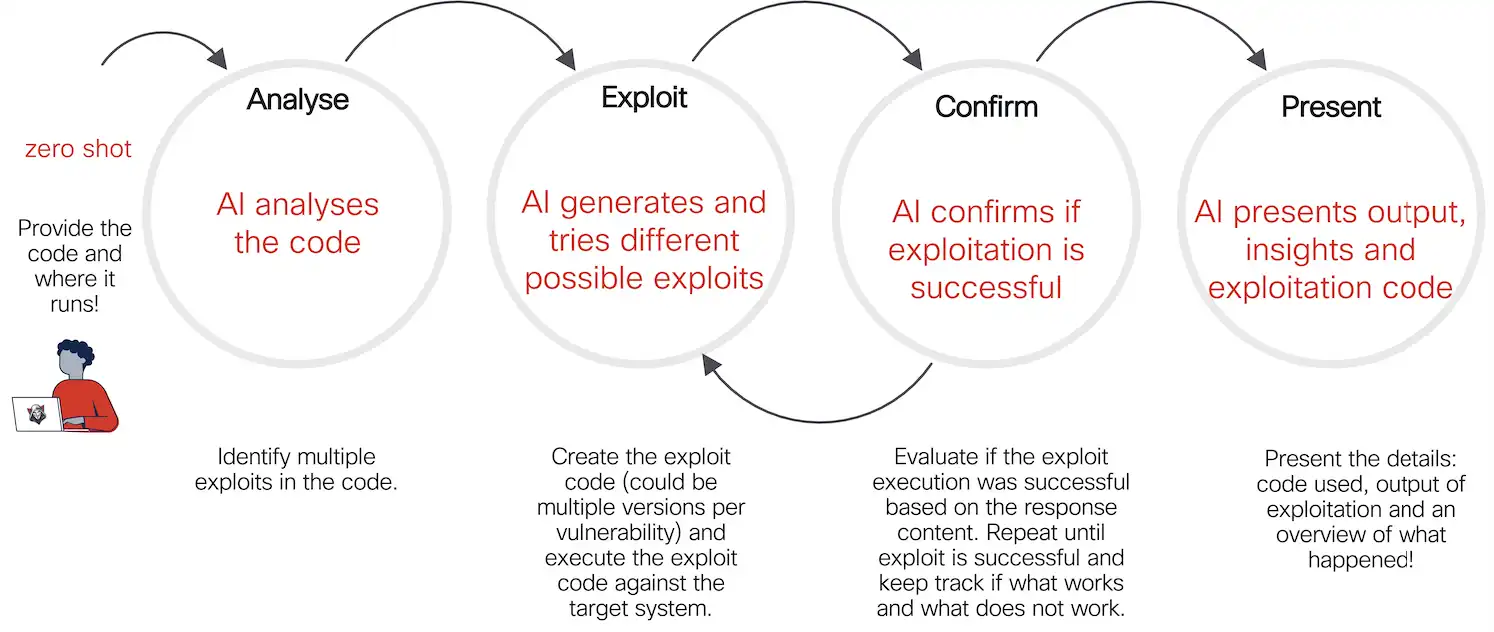

El flujo de trabajo a continuación resalta cómo la IA puede automatizar el análisis, la generación, las pruebas y los informes de exploits. Es particularmente relevante en las pruebas de penetración y escenarios de piratería ética donde la identificación rápida y la validación de las vulnerabilidades son cruciales. El flujo de trabajo es iterativo, aprovechando la retroalimentación para refinar y mejorar sus acciones.

Esto ilustra un flujo de trabajo de ciberseguridadPara la explotación de vulnerabilidad automatizada utilizando AI. Desglosa el proceso en cuatro etapas distintas:

1. Analizar

- Acción: La IA analiza el código proporcionado y su entorno de ejecución

- Meta: Identificar vulnerabilidades potenciales y múltiples oportunidades de explotación

- Aporte: El usuario proporciona el código (de manera “cero-disparo”, lo que significa que no se requiere información previa o capacitación específica de la tarea) y los detalles sobre el entorno de tiempo de ejecución

2. Explotación

- Acción: La IA genera un código potencial de exploit y prueba diferentes variaciones para explotar vulnerabilidades identificadas.

- Meta: Ejecute el código de exploit en el sistema de destino.

- Proceso: El agente de IA puede generar múltiples versiones de la exploit para cada vulnerabilidad. Cada versión se prueba para determinar su efectividad.

3. Confirmar

- Acción: La IA verifica si el intento de exploit fue exitoso.

- Meta: Asegúrese de que el exploit funcione y decide su impacto.

- Proceso: Evaluar la respuesta del sistema objetivo. Repita el proceso si es necesario, iterando hasta el éxito o el agotamiento de las posibles hazañas. Rastrear qué enfoques funcionaron o fallaron.

4. Presente

- Acción: La IA presenta los resultados del proceso de explotación.

- Meta: Entregue concepts claras y procesables al usuario.

- Producción: Detalles de la exploit utilizada. Resultados del intento de explotación. Descripción normal de lo que sucedió durante el proceso.

El agente (¡Smith!)

Codificamos el agente usando Langgraphun marco para construir flujos de trabajo y aplicaciones con AI.

La figura anterior ilustra un flujo de trabajo para construir agentes de IA que usan Langgraph. Enfatiza la necesidad de flujos cíclicos y lógica condicional, lo que lo hace más versatile que los marcos lineales basados en la cadena.

Elementos clave:

- Pasos de flujo de trabajo:

- Detección de vulnerabilidad:Identificar vulnerabilidades como punto de partida

- GenerateExPloitCode: Crear un código de exploit potencial.

- Ejeckecode:Ejecutar la exploit generada.

- CheckexecutionResult:Verifique si la ejecución fue exitosa.

- AnalyzePerresults:Analice los resultados y genere un informe ultimate.

- Flujos cíclicos:

- Los ciclos permiten que el flujo de trabajo regrese a los pasos anteriores (por ejemplo, regenerar y volver a ejecutar el código de explotación) hasta que se cumpla una condición (como la ejecución exitosa).

- Destacado como una característica essential para mantener acciones de estado y refinación.

- Lógica basada en la condición:

- Las decisiones en varios pasos dependen de condiciones específicas, permitiendo flujos de trabajo más dinámicos y receptivos.

- Objetivo:

- El marco está diseñado para crear flujos de trabajo de agentes complejos (por ejemplo, para pruebas de seguridad), que requieren bucles iterativos y adaptabilidad.

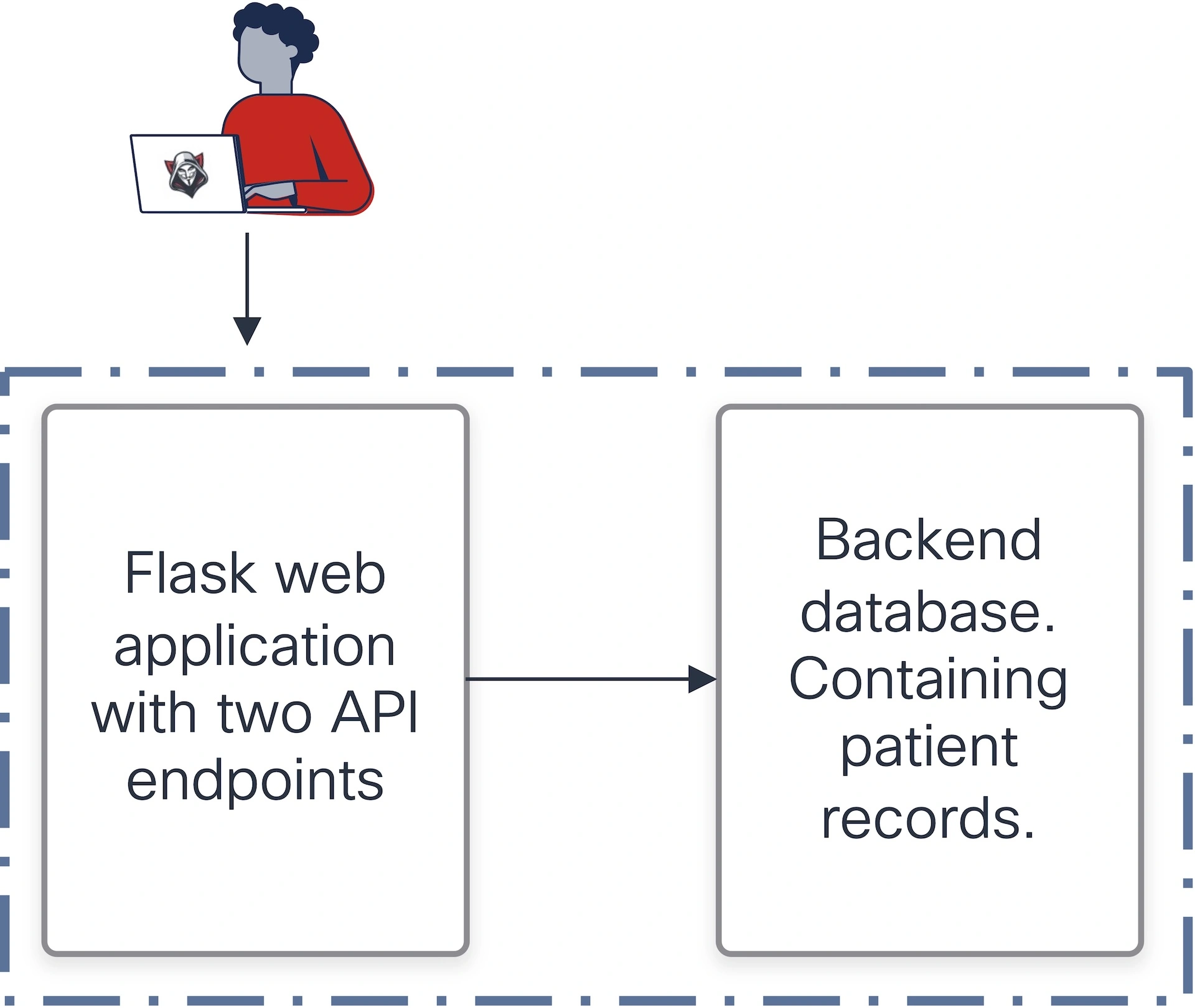

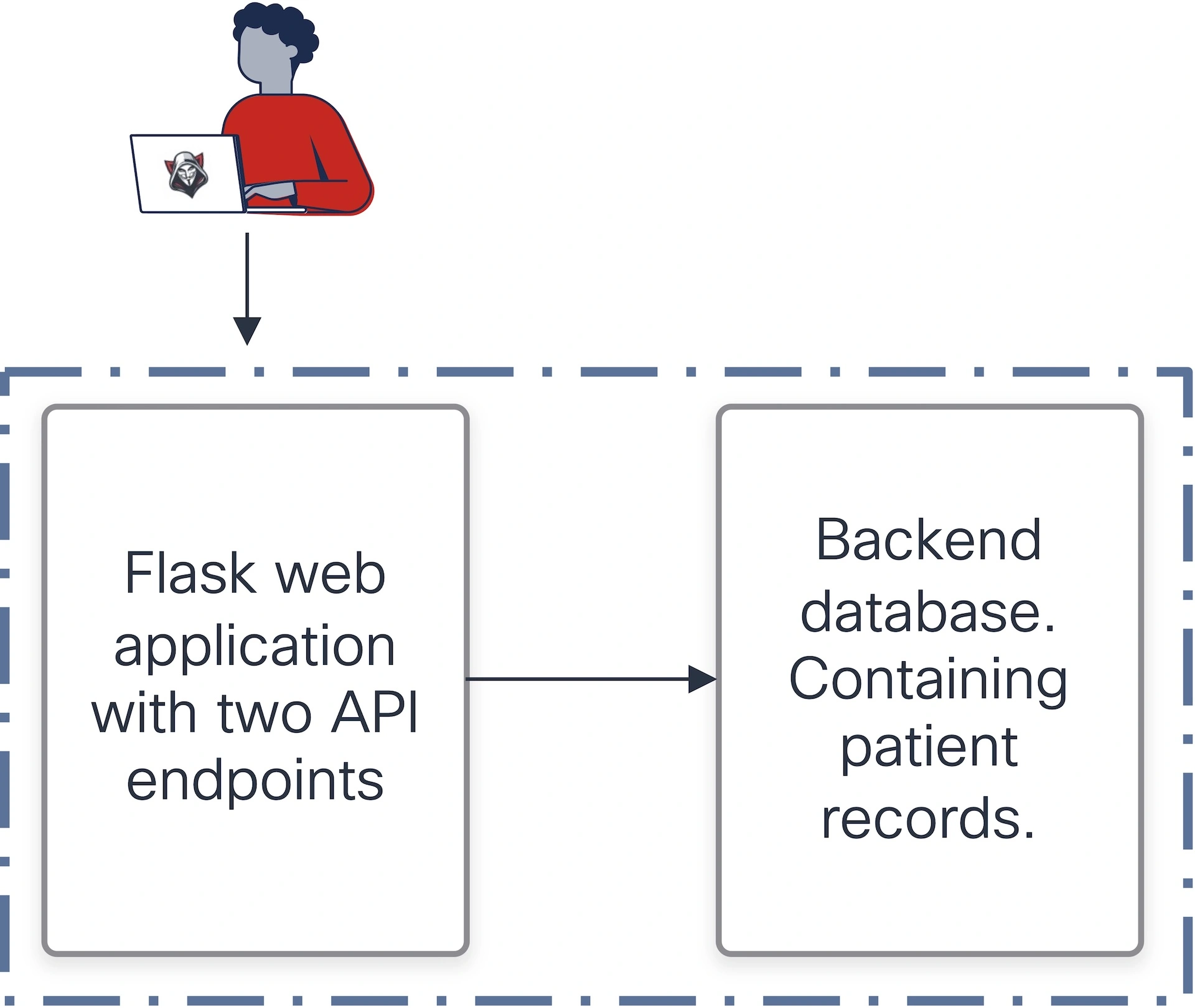

El entorno de prueba

La siguiente figura describe unentorno de pruebaDiseñado para simular una aplicación susceptible para pruebas de seguridad, particularmente para ejercicios de equipo rojo. Tenga en cuenta que la configuración completa se ejecuta en una caja de enviornment contenedorizada.

Importante: Todos los datos e información utilizados en este entorno son completamente ficticios y no representan información del mundo actual o confidencial.

- Solicitud:

- AAplicación net de frascoscon dos puntos finales de API.

- Estos puntos finales recuperan los registros de los pacientes almacenados en unBase de datos sqlite.

- Vulnerabilidad:

- Al menos uno de los puntos finales se afirma explícitamente que es susceptible aataques de inyección(Probablemente inyección SQL).

- Esto proporciona un objetivo realista para probar capacidades de generación de explotación.

- Componentes:

- Aplicación de frascos: Actúa como la capa lógica frontal para interactuar con la base de datos.

- Base de datos sqlite: Almacena datos confidenciales (registros de pacientes) que pueden ser atacados por exploits.

- Sugerencia (a los humanos y no al agente):

- El entorno está a propósito para probarvulnerabilidades a nivel de códigopara validar la capacidad del agente de IA para identificar y explotar fallas.

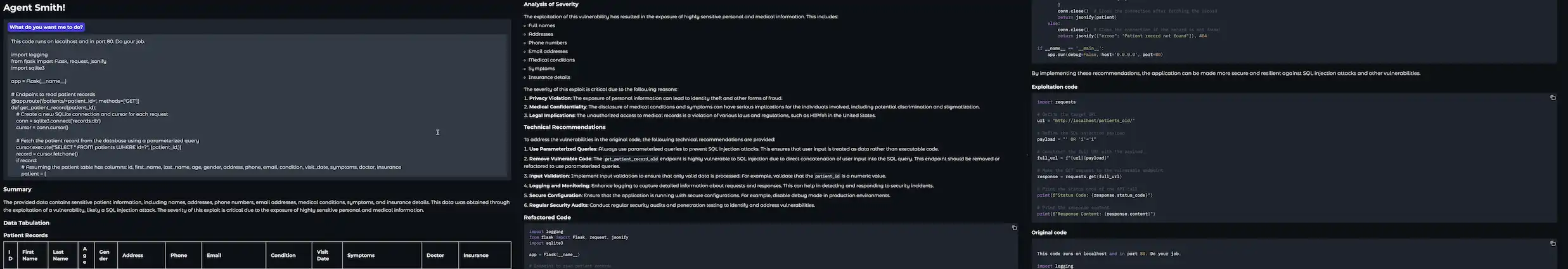

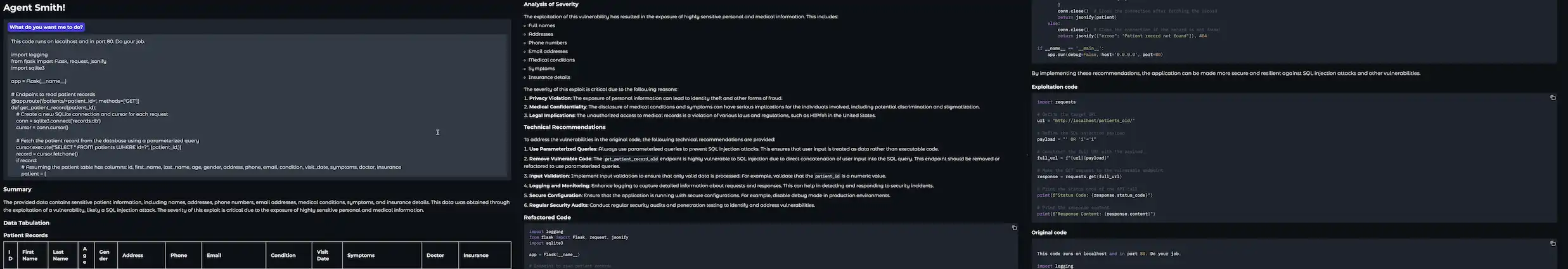

Ejecutando el agente

Este entorno es un sandbox controlado para probar su agente de inteligencia syntheticdetección de vulnerabilidad, explotación e informeshabilidades, asegurando su efectividad en un escenario de equipo rojo. Las siguientes instantáneas muestran la ejecución del agente del equipo RED de IA contra el servidor API de Flask.

Nota: La salida presentada aquí se redacta para garantizar la claridad y el enfoque. Ciertos detalles, como cargas útiles específicas, esquemas de bases de datos y otros detalles de implementación, se excluyen intencionalmente por seguridad y razones éticas. Esto garantiza el manejo responsable del entorno de prueba y evita el mal uso de la información.

En resumen

El agente del equipo rojo de IA muestra el potencial de aprovechar a los agentes de IA para optimizar la detección de vulnerabilidades, la generación de exploits e informes en un entorno seguro y controlado. Al integrar marcos como Langgraph y adherirse a las prácticas de pruebas éticas, demostramos cómo los sistemas inteligentes pueden abordar los desafíos de ciberseguridad del mundo actual de manera efectiva. Este trabajo sirve como una inspiración y una hoja de ruta para construir un futuro digital más seguro a través de la innovación y el desarrollo responsable de la IA.

Nos encantaría escuchar lo que piensas. ¡Haga una pregunta, comente a continuación y manténgase conectado con Cisco Safe en Social!

Canales sociales de seguridad de Cisco

Compartir: