El dron impulsado por IA de la Universidad de Klagenfurt usa Ids ueye Cámara para la navegación relativa a objetos en tiempo actual, habilitando inspecciones más seguras, más eficientes y precisas.

La inspección de infraestructuras críticas como plantas de energía, puentes o complejos industriales es esencial para garantizar su seguridad, confiabilidad y funcionalidad a largo plazo. Los métodos de inspección tradicionales siempre requieren el uso de personas en áreas que son difíciles de acceder o riesgosos. Los robots móviles autónomos ofrecen un gran potencial para hacer que las inspecciones sean más eficientes, seguras y más precisas. Los vehículos aéreos no introducidos (UAV) como los drones en explicit se han establecido como plataformas prometedoras, ya que pueden usarse de manera versatile e incluso pueden alcanzar áreas que son difíciles de acceder desde el aire. Uno de los mayores desafíos aquí es navegar por el dron precisamente en relación con los objetos que se inspeccionarán para capturar de manera confiable los datos de imagen de alta resolución u otros datos del sensor.

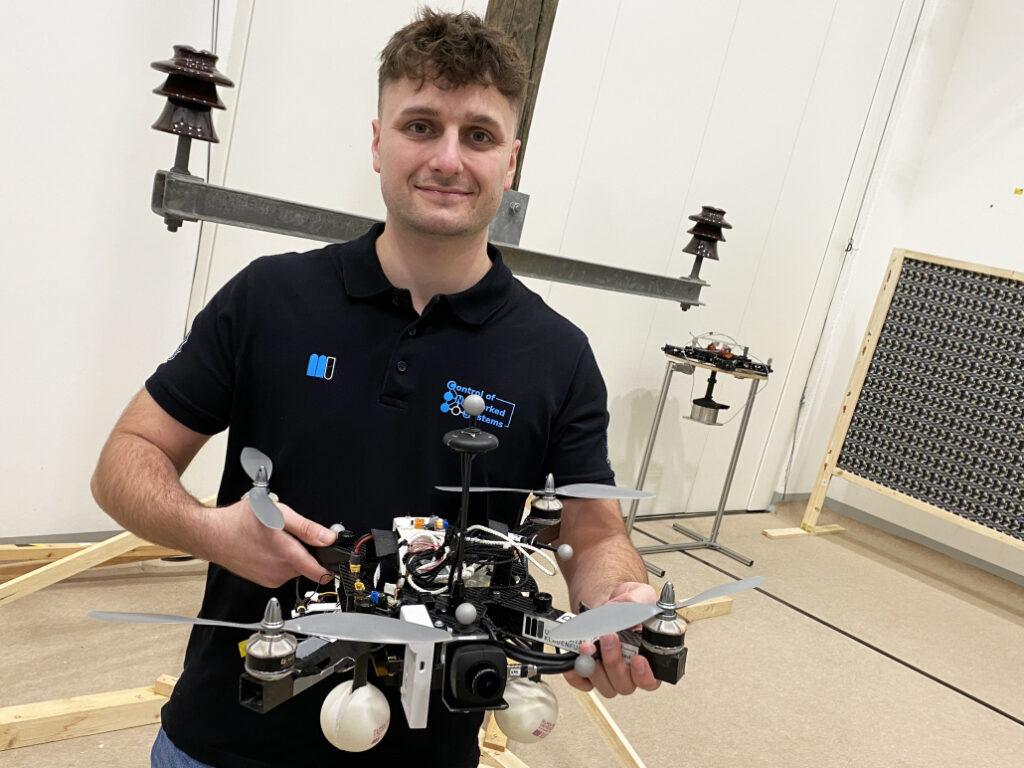

Un grupo de investigación de la Universidad de Klagenfurt ha diseñado un dron capaz en tiempo actual basado en la navegación relativa a objetos utilizando inteligencia synthetic. También a bordo: una cámara industrial USB3 Imaginative and prescient de la familia Ueye Le de IDS Imaging Improvement Programs GmbH.

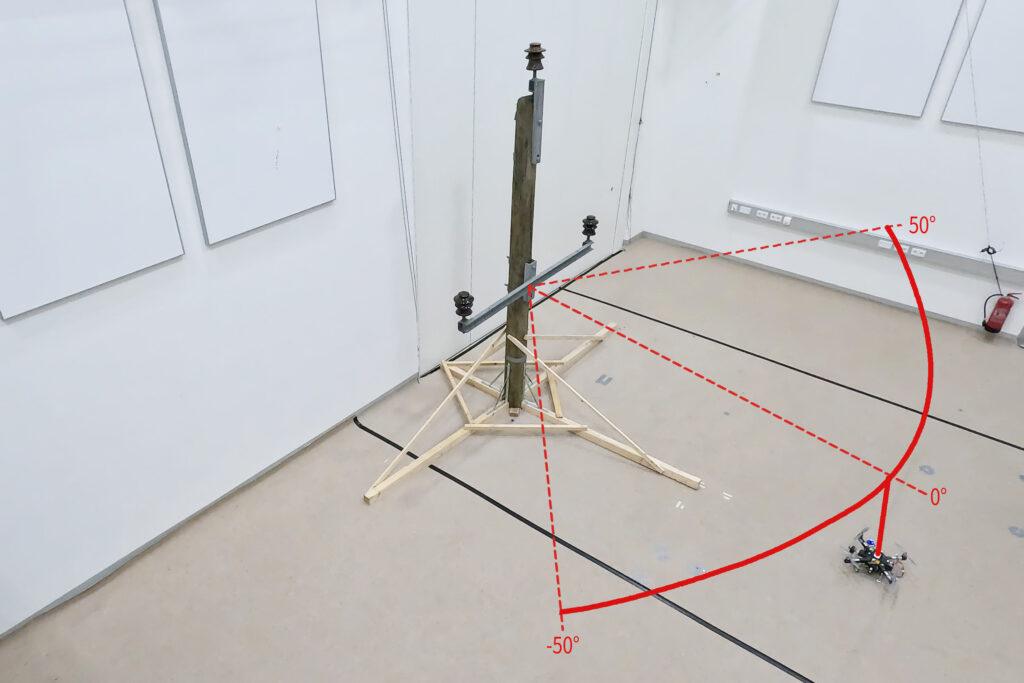

Como parte del proyecto de investigación, que fue financiado por el Ministerio Federal de Austria para la Acción Climática, el Medio Ambiente, la Energía, la Movilidad, la Innovación y la Tecnología (BMK), el dron debe reconocer de forma autónoma lo que es un poste de potencia y qué es un aislante en el Energy Pole. Volará alrededor del aislante a una distancia de tres metros y tomará fotos. “La localización precisa es importante de tal manera que las grabaciones de la cámara también se puedan comparar en múltiples vuelos de inspección”, explica Thomas Georg Jantos, estudiante de doctorado y miembro del Grupo de Investigación de Sistemas en Redes en la Universidad de Klagenfurt. El requisito previo para esto es que la navegación relativa a los objetos debe poder extraer la llamada información semántica sobre los objetos en cuestión de los datos sensoriales sin procesar capturados por la cámara. La información semántica hace datos sin procesar, en este caso las imágenes de la cámara, “comprensible” y hace posible no solo capturar el entorno, sino también identificar y localizar correctamente los objetos relevantes.

En este caso, esto significa que un píxel de imagen no solo se entiende como un valor de coloration independiente (por ejemplo, valor RGB), sino como parte de un objeto, por ejemplo, un aislador. A diferencia de los GNN clásicos (sistema de satélite de navegación international), este enfoque no solo proporciona una posición en el espacio, sino también una posición y orientación relativa precisa con respecto al objeto a inspeccionar (por ejemplo, „dron se encuentra 1.5m a la izquierda del insulador superior”).

El requisito clave es que el procesamiento de imágenes y la interpretación de datos deben estar libres de latencia para que el dron pueda adaptar su navegación e interacción a las condiciones y requisitos específicos de la tarea de inspección en tiempo actual.

Información semántica a través del procesamiento de imágenes inteligentes

El reconocimiento de objetos, la clasificación de objetos y la estimación de pose de objetos se realizan utilizando inteligencia synthetic en el procesamiento de imágenes. “En contraste con los enfoques de inspección basados en GNSS que usan drones, nuestra IA con su información semántica permite que la inspección de la infraestructura se inspeccione desde ciertos puntos de vista reproducibles”, explica Thomas Jantos. “Además, el enfoque elegido no sufre los problemas de GNSS habituales, como la múltiples patas y el sombreado, causados por grandes infraestructuras o valles, lo que puede conducir a la degradación de la señal y, por lo tanto, a los riesgos de seguridad”.

¿Cuánto AI se ajusta a un pequeño quadcopter?

La configuración de {hardware} consiste en una plataforma de Copter de Ciencias Twins equipada con un pixhawk PX4 Autopilot, un Devkit Nvidia Jetson Orin AGX 64GB como computadora a bordo y una cámara industrial USB3 Imaginative and prescient de IDS. „El desafío es obtener la inteligencia synthetic en los pequeños helicópteros.

Las computadoras en el dron todavía son demasiado lentas en comparación con las computadoras utilizadas para entrenar la IA. Con las primeras pruebas exitosas, este sigue siendo el tema de la investigación precise “, cube Thomas Jantos, que describe el problema de optimizar aún más el modelo AI de alto rendimiento para su uso en la computadora a bordo.

La cámara, por otro lado, ofrece datos básicos perfectos de inmediato, como muestran las pruebas en el propio Drone Corridor de la universidad. Al seleccionar un modelo de cámara adecuado, no period solo una cuestión de cumplir con los requisitos en términos de velocidad, tamaño, clase de protección y, por último, pero no menos importante. “Las capacidades de la cámara son esenciales para el innovador algoritmo de navegación basado en IA del sistema de inspección”, cube Thomas Jantos. Optó por el modelo C-HQ U3-3276LE, una cámara de proyecto de ahorro de espacio y rentable de la familia Ueye Le. El sensor integrado Sony Pregius IMX265 es probablemente el mejor sensor de imagen CMOS en la clase de 3 MP y permite una resolución de 3.19 megapíxeles (2064 x 1544 px) con una velocidad de cuadro de hasta 58.0 fps. El obturador international integrado de 1/1.8 ″, que no produce imágenes “distorsionadas” en estos tiempos de exposición cortos en comparación con un obturador rodante, es decisivo para el rendimiento del sensor. “Para garantizar un vuelo de inspección seguro y robusto, la alta calidad de imagen y las velocidades de cuadro son esenciales”, enfatiza Thomas Jantos. Como cámara de navegación, el UEYE LE proporciona a la IA integrada los datos de imagen integrales que la computadora a bordo necesita calcular la posición relativa y la orientación con respecto al objeto a inspeccionar. Según esta información, el dron puede corregir su pose en tiempo actual.

La cámara IDS está conectada a la computadora integrada a través de una interfaz USB3. “Con la ayuda del IDS Peak SDK, podemos integrar la cámara y sus funcionalidades muy fácilmente en el ROS (sistema operativo robotic) y, por lo tanto, en nuestro dron”, explica Thomas Jantos. IDS Peak también permite un procesamiento eficiente de imágenes sin procesar y un ajuste easy de los parámetros de grabación, como la exposición automática, el equilibrio de blanco automático, la ganancia automática y la reducción de imágenes.

Para garantizar un alto nivel de autonomía, management, gestión de la misión, monitoreo de seguridad y registro de datos, los investigadores utilizan la pila de vuelo del CNS disponible en la computadora a bordo. La pila de vuelo del CNS incluye módulos de software program para la navegación, algoritmos de fusión y management del sensor y permite la ejecución autónoma de misiones reproducibles y personalizables. „La modularidad de la pila de vuelo del CNS y las interfaces ROS nos permiten integrar sin problemas nuestros sensores y el ‘estimador de estado’ basado en AI para la detección de posición en toda la pila y, por lo tanto, realizar vuelos autónomos de UAV. La funcionalidad de nuestro enfoque se analiza y se desarrolla utilizando el ejemplo de un vuelo de inspección alrededor de un polo de potencia en la sala de ronos en la Universidad de Klagenfurt,” explica el vuelo de Jantos.

Alineación precisa y autónoma a través de la fusión del sensor

Las señales de management de alta frecuencia para el dron son generadas por la IMU (unidad de medición inercial). La fusión del sensor con datos de cámara, LIDAR o GNSS (sistema de satélite de navegación international) permite la navegación y estabilización en tiempo actual del dron, por ejemplo, para las correcciones de posición o la alineación precisa con los objetos de inspección. Para el dron Klagenfurt, el IMU del PX4 se usa como un modelo dinámico en un EKF (filtro Kalman extendido). El EKF estima dónde el dron debe estar ahora basado en la última posición, velocidad y actitud conocidas. Luego se registran nuevos datos (por ejemplo, de IMU, GNSS o cámara) a hasta 200 Hz e incorporado en el proceso de estimación de estado.

La cámara captura imágenes sin procesar a 50 fps y un tamaño de imagen de 1280 x 960px. “Esta es la velocidad de cuadro máxima que podemos lograr con nuestro modelo AI en la computadora a bordo del dron”, explica Thomas Jantos. Cuando se inicia la cámara, se lleva a cabo un ajuste automático de stability de blancos y ganancia una vez, mientras que el management de exposición automático permanece apagado. El EKF compara la predicción y la medición y corrige la estimación en consecuencia. Esto asegura que el dron permanezca estable y pueda mantener su posición de forma autónoma con alta precisión.

Perspectiva

„Con respecto a la investigación en el campo de los robots móviles, las cámaras industriales son necesarias para una variedad de aplicaciones y algoritmos. Es importante que estas cámaras sean robustas, compactas, livianas, rápidas y tienen una alta resolución. En el servicio de preprocesamiento (por ejemplo) también es muy importante, ya que ahorra tiempo valioso y recursos en el robotic móvil,” enfatiza los jantos.

Con las características correspondientes, las cámaras IDS están ayudando a establecer un nuevo estándar en la inspección autónoma de las infraestructuras críticas en este prometedor enfoque de investigación, que aumenta significativamente la seguridad, la eficiencia y la calidad de los datos.

El management del grupo de investigación de sistemas en purple (SNC) es parte del Instituto de Tecnologías de Sistemas Inteligentes. Está involucrado en la enseñanza en los programas de licenciatura y maestría en inglés “Robótica e IA” y “Ingeniería de Información y Comunicaciones (ICE)” en la Universidad de Klagenfurt. La investigación del grupo se centra en la ingeniería de management, la estimación del estado, la planificación de la ruta y el movimiento, el modelado de sistemas dinámicos, simulaciones numéricas y la automatización de robots móviles en un enjambre: Más información

Modelo utilizado:USB3 Imaginative and prescient Industriekamera U3-3276le Rev.1.2

Familia de la cámara: Ueye le

Derechos de la imagen: Alpen-Adria-Universität (AAU) Klagenfurt

© 2025 IDS Sistemas de desarrollo de imágenes GMBH

Ähnliche beiträge