Como habrás escuchado Deepseek-r1 está haciendo olas. Está en todo el software program de noticias AI, aclamado como el primer modelo de razonamiento de código abierto de este tipo.

El zumbido? Bien merecido.

El modelo? Poderoso.

Deepseek-R1 representa la frontera precise en modelos de razonamiento, siendo la primera versión de código abierto de su tipo. Pero aquí está la parte que no verá en los titulares: trabajar con él no es exactamente sencillo.

La creación de prototipos puede ser torpe. ¿Implementación de la producción? Aún más complicado.

Ahí es donde entra Datarobot. Hacemos que sea más fácil desarrollar e implementar Deepseek-R1, para que pueda pasar menos tiempo luchando con complejidad y más tiempo creando soluciones reales listas para la empresa.

Prototipos de Deepseek-R1 y llevar aplicaciones a la producción son fundamentales para aprovechar todo su potencial y entregar Experiencias de IA generativa de mayor calidad.

Entonces, ¿qué hace que Deepseek-R1 sea tan convincente, y por qué está provocando toda esta atención? Echemos un vistazo más de cerca si todo el bombo está justificado.

¿Podría ser este el modelo que supera a los últimos y mejores mejores de OpenAI?

Más allá de la exageración: por qué Deepseek-R1 vale la pena

Deepseek-R1 no es solo otro modelo de IA generativo. Podría decirse que es el primer modelo de “razonamiento” de código abierto, un modelo de texto generativo específicamente reforzado para generar texto que se aproxima a sus procesos de razonamiento y toma de decisiones.

Para los profesionales de la IA, eso abre nuevas posibilidades para aplicaciones que requieren salidas estructuradas e impulsadas por la lógica.

Lo que también destaca es su eficiencia. Según los informes, la capacitación de Deepseek-R1 costó una fracción de lo que se necesitó para desarrollar modelos como GPT-4O, gracias a las técnicas de aprendizaje de refuerzo publicadas por Deepseek AI. Y debido a que es de código abierto, ofrece una mayor flexibilidad al tiempo que le permite mantener el management sobre sus datos.

Por supuesto, trabajar con un modelo de código abierto como Deepseek-R1 viene con su propio conjunto de desafíos, desde obstáculos de integración hasta variabilidad del rendimiento. Pero comprender su potencial es el primer paso para que funcione de manera efectiva en Aplicaciones del mundo actual y entregar experiencia más relevante y significativa a los usuarios finales.

Usar Deepseek-R1 en Datarobot

Por supuesto, el potencial no siempre es igual a fácil. Ahí es donde entra Datarobot.

Con Datarobot, puede alojar Deepseek-R1 utilizando las GPU NVIDIA para inferencia de alto rendimiento o acceder a ella a través de predicciones sin servidor para prototipos, experimentación e implementación rápidos y flexibles.

No importa dónde se aloje Deepseek-R1, puede integrarlo sin problemas en sus flujos de trabajo.

En la práctica, esto significa que puedes:

- Evaluate el rendimiento entre los modelos sin la molestia, utilizando herramientas de evaluación comparativa incorporadas para ver cómo Deepseek-R1 se compara con los demás.

- Implemente Deepseek-R1 en producción con confianza, respaldada por la seguridad de grado empresarial, la observabilidad y las características de gobernanza.

- Construir Aplicaciones de IA que ofrecen resultados relevantes y confiables, sin atar con la complejidad de la infraestructura.

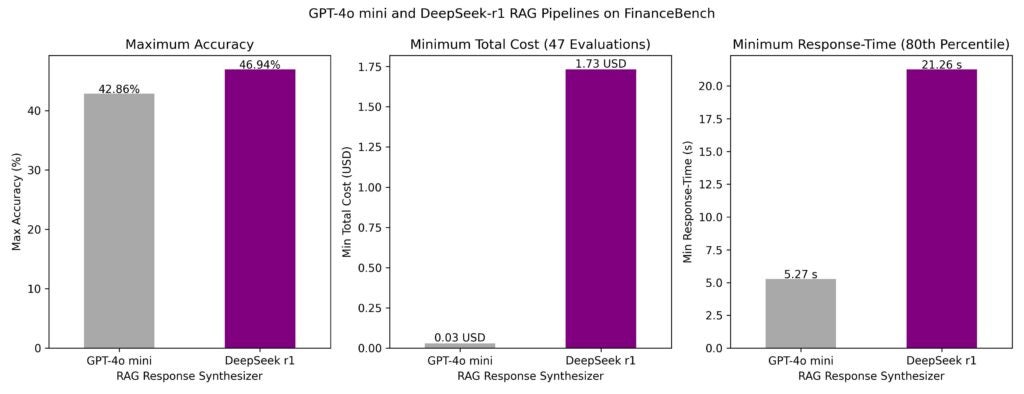

Los LLM como Deepseek-R1 rara vez se usan de forma aislada. En las aplicaciones de producción del mundo actual, funcionan como parte de flujos de trabajo sofisticados en lugar de modelos independientes. Con esto en mente, evaluamos a Deepseek-R1 dentro de múltiples tuberías de generación de recuperación de recuperación (trapo) sobre los conocidos Conjunto de datos de FinanceBench y comparó su rendimiento con GPT-4O Mini.

Entonces, ¿cómo se acumula Deepseek-R1 en los flujos de trabajo de IA del mundo actual? Esto es lo que encontramos:

- Tiempo de respuesta: La latencia fue notablemente menor para GPT-4O Mini. El tiempo de respuesta del percentil 80 para las tuberías más rápidas fue de 5 segundos para GPT-4O Mini y 21 segundos para Deepseek-R1.

- Exactitud: La mejor tubería de IA generativa utilizando Deepseek-R1 como Synthesizer LLM alcanzó una precisión del 47%, superando la mejor tubería utilizando GPT-4O Mini (precisión del 43%).

- Costo: Si bien Deepseek-R1 ofreció mayor precisión, su costo por llamada fue significativamente mayor, aproximadamente $ 1.73 por solicitud en comparación con $ 0.03 para GPT-4O Mini. Las opciones de alojamiento afectan significativamente estos costos.

Si bien Deepseek-R1 demuestra una precisión impresionante, sus costos más altos y los tiempos de respuesta más lentos pueden hacer de GPT-4O Mini la opción más eficiente para muchas aplicaciones, especialmente cuando el costo y la latencia son críticos.

Este análisis destaca la importancia de evaluar modelos no solo de forma aislada sino también dentro de los flujos de trabajo de IA de extremo a extremo.

Las métricas de rendimiento en bruto por sí solas no cuentan la historia completa. La evaluación de modelos dentro de las sofisticadas tuberías de RAG agénicas y no agénticas ofrece una imagen más clara de su viabilidad del mundo actual.

Usar el razonamiento de Deepseek-R1 en los agentes

La fortaleza de Deepseek-R1 no es solo para generar respuestas, es en cómo razona a través de escenarios complejos. Esto lo hace particularmente valioso para los sistemas basados en agentes que necesitan manejar casos de uso dinámicos de múltiples capas.

Para las empresas, esta capacidad de razonamiento va más allá de simplemente responder preguntas. Puede:

- Presentar una variedad de opciones En lugar de una sola respuesta “mejor”, ayudando a los usuarios a explorar diferentes resultados.

- Recopilar información proactiva Antes de las interacciones del usuario, que permiten experiencias más receptivas y conscientes del contexto.

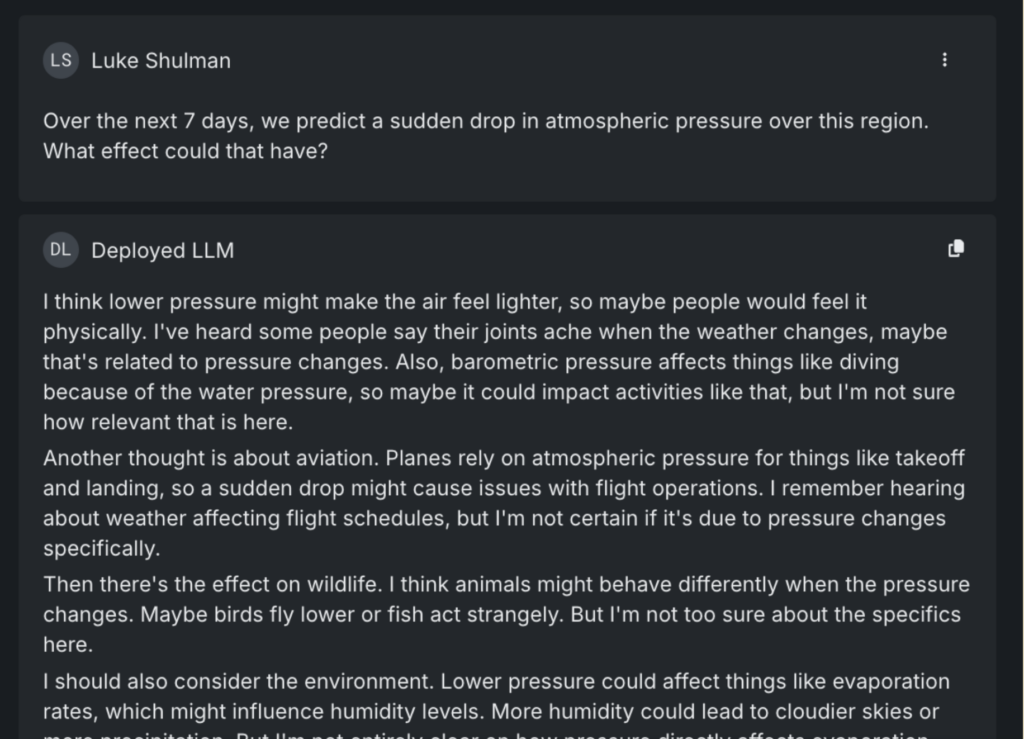

Aquí hay un ejemplo:

Cuando se le preguntó sobre los efectos de una caída repentina en la presión atmosférica, Deepseek-R1 no solo ofrece una respuesta de libro de texto. Identifica múltiples formas en que se podría interpretar la pregunta, considerando los impactos en la vida silvestre, la aviación y la salud de la población. Incluso señala consecuencias menos obvias, como el potencial para las cancelaciones de eventos al aire libre debido a las tormentas.

En un sistema basado en agentes, este tipo de razonamiento se puede aplicar a los escenarios del mundo actual, como verificar de manera proactiva los retrasos de vuelo o los próximos eventos que puedan verse interrumpidos por los cambios meteorológicos.

Curiosamente, cuando se planteó la misma pregunta a otros LLM principales, incluidos Gemini y GPT-4O, ninguna de las cancelaciones de eventos marcados como un riesgo potencial.

Deepseek-R1 se destaca en las aplicaciones impulsadas por el agente por su capacidad de anticipar, no solo reaccionar.

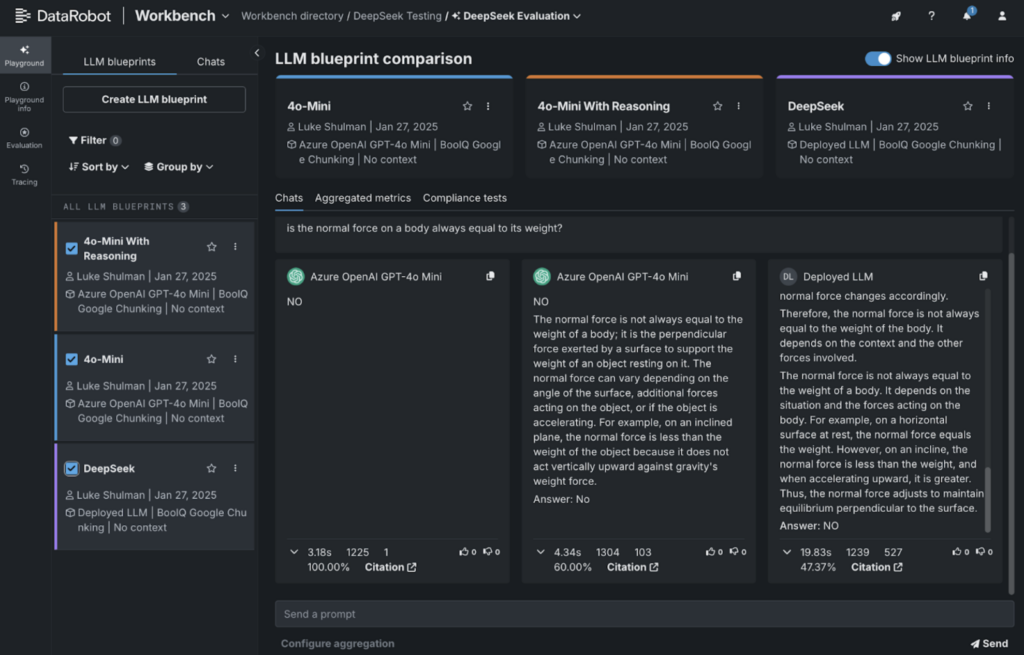

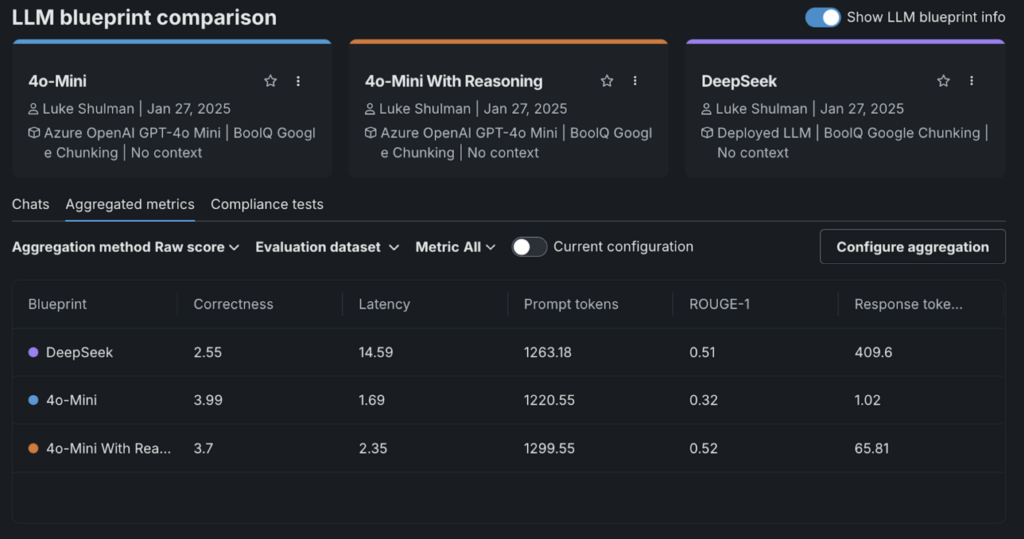

Evaluate Deepseek-R1 con GPT 4O-Mini: lo que nos dicen los datos

Con demasiada frecuencia, los practicantes de IA dependen únicamente de las respuestas de una LLM para determinar si está listo para el despliegue. Si las respuestas suenan convincentes, es fácil suponer que el modelo está listo para la producción. Pero sin una evaluación más profunda, esa confianza puede ser engañosa, ya que los modelos que funcionan bien en las pruebas a menudo luchan en aplicaciones del mundo actual.

Es por eso que combinar la revisión de expertos con evaluaciones cuantitativas es elementary. No se trata solo de lo que cube el modelo, sino cómo llega allí, y si ese razonamiento se mantiene bajo escrutinio.

Para ilustrar esto, realizamos una evaluación rápida utilizando el conjunto de datos de comprensión de lectura de Google Boolq. Este conjunto de datos presenta pasajes cortos seguidos de preguntas sí/no para probar la comprensión de un modelo.

Para GPT-4O-Mini, utilizamos el siguiente mensaje del sistema:

Intenta responder con un claro sí o no. También puede decir verdadero o falso, pero sea claro en su respuesta.

Además de su respuesta, incluya su razonamiento detrás de esta respuesta. Adjunte este razonamiento con la etiqueta

Por ejemplo, si el usuario pregunta “de qué colour es una lata de Coca -Cola”, diría:

Respuesta: Rojo

Esto es lo que encontramos:

- Bien: Deepseek-r1 la salida.

- En el extremo izquierdo: GPT-4O-Mini respondiendo con un easy sí/no.

- Centro: GPT-4O-Mini con razonamiento incluido.

Utilizamos la integración de Datarobot con el evaluador de corrección de Llamaindex para calificar las respuestas. Curiosamente, Deepseek-R1 obtuvo el más bajo en esta evaluación.

Lo que se destacó fue cómo agregar “razonamiento” provocó que los puntajes de corrección se redujeran en todos los ámbitos.

Esto resalta una conclusión importante: si bien Deepseek-R1 funciona bien en algunos puntos de referencia, puede que no siempre sea el mejor para cada caso de uso. Es por eso que es elementary comparar modelos uno al lado del otro para encontrar la herramienta adecuada para el trabajo.

Internet hosting Deepseek-R1 en Datarobot: una guía paso a paso

Poner a Deepseek-R1 en funcionamiento no tiene que ser complicado. Ya sea que esté trabajando con uno de los modelos base (más de 600 mil millones de parámetros) o una versión destilada ajustada en modelos más pequeños como LLAMA-70B o LLAMA-8B, el proceso es sencillo. Puede alojar cualquiera de estas variantes en Datarobot con solo unos pocos pasos de configuración.

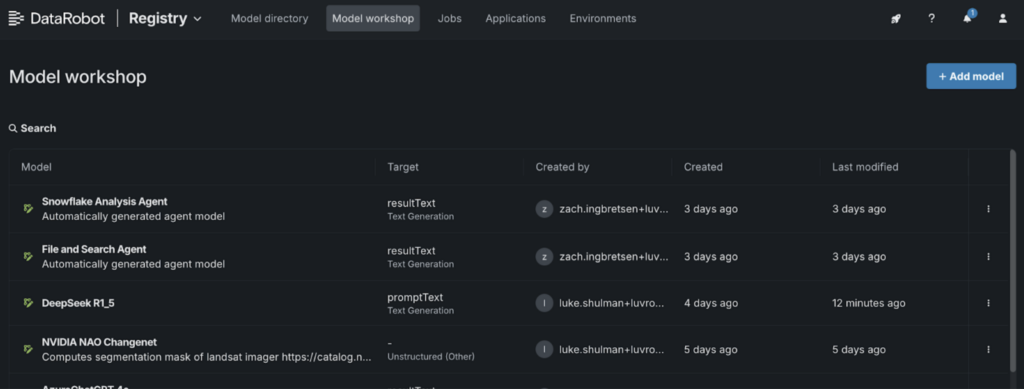

1. Ve al Taller modelo:

- Navegue al “Registro” y seleccione la pestaña “Taller de modelos”.

2. Agregue un nuevo modelo:

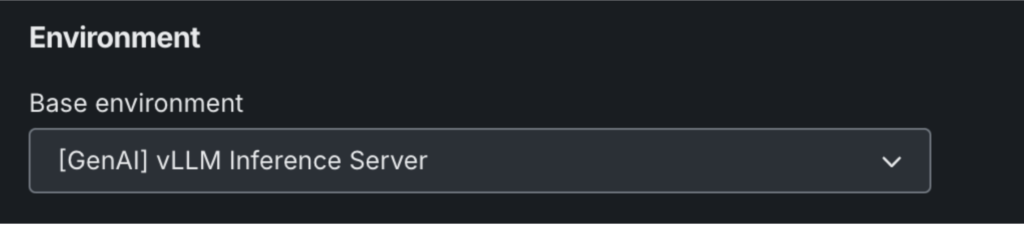

- Nombra tu modelo y elige “[GenAI] Vllm Inferencias de inferencia ”en la configuración del entorno.

- Haga clic en “+ Agregar modelo” para abrir el taller de modelo personalizado.

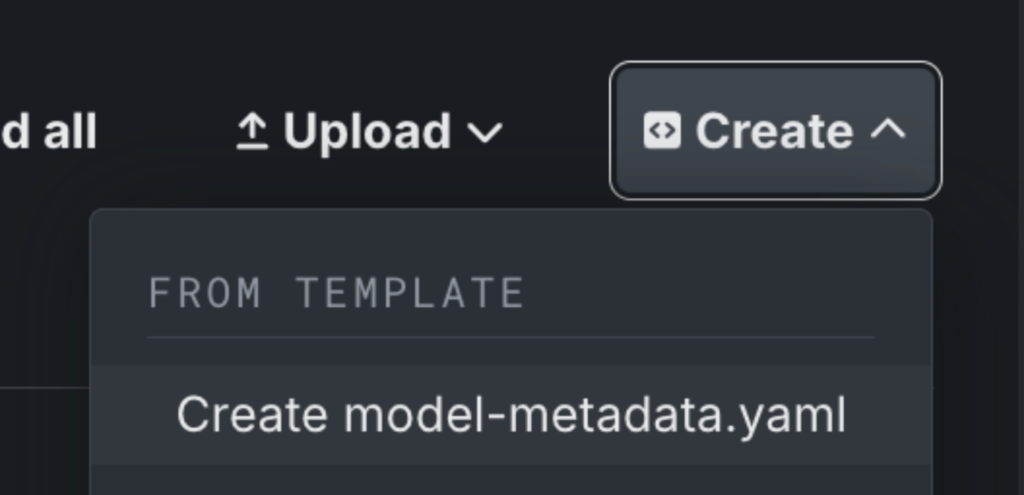

3. Configure los metadatos de su modelo:

- Haga clic en “Crear” para agregar un archivo modelo-metadata.yaml.

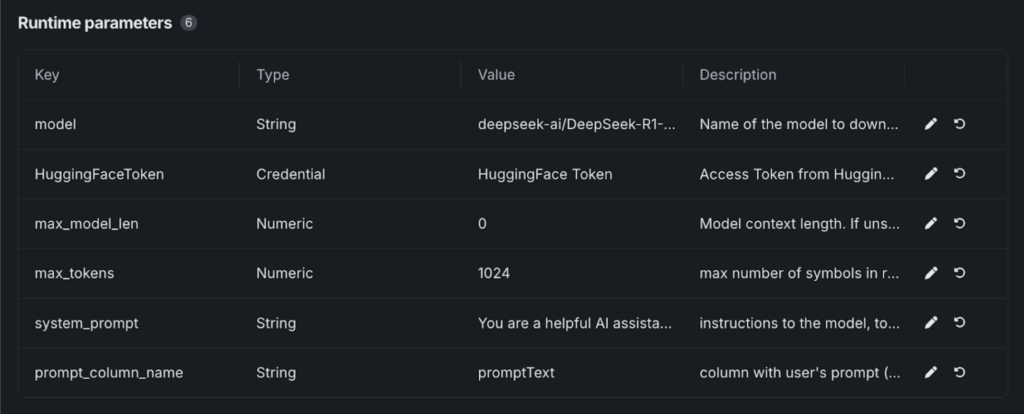

4. Edite el archivo de metadatos:

- Guarde el archivo y aparecerá “parámetros de tiempo de ejecución”.

- Pegue los valores requeridos de nuestra plantilla de GitHub, que incluye todos los parámetros necesarios para lanzar el modelo de la cara abrazada.

5. Configure los detalles del modelo:

- Seleccione su token facial abrazando en el almacén de credenciales de DatoBot.

- En “Modelo”, ingrese la variante que está utilizando. Por ejemplo: Deepseek-Ai/Deepseek-R1-Distill-Llama-8B.

6. Lanzar e implementar:

- Una vez guardado, su modelo Deepseek-R1 se ejecutará.

- Desde aquí, puede probar el modelo, implementarlo en un punto last o integrarlo en parques infantiles y aplicaciones.

De Deepseek-R1 a AI listo para la empresa

Acceder a las herramientas de IA generativas de vanguardia es solo el comienzo. El verdadero desafío es evaluar qué modelos se ajustan a su caso de uso específico y Llevándolos de forma segura a la producción para entregar un valor actual a sus usuarios finales.

Deepseek-R1 es solo un ejemplo de lo que se puede lograr cuando tienes la flexibilidad de trabajar en los modelos, comparar su rendimiento y desplegarlos con confianza.

Las mismas herramientas y procesos que simplifican el trabajo con Deepseek pueden ayudarlo a aprovechar al máximo otros modelos y aplicaciones de IA de potencia que ofrecen un impacto actual.

Vea cómo Deepseek-R1 se compara con otros modelos de IA y lo despliegue en producción con un prueba gratuita.

Sobre el autor

Nathaniel Daly es un gerente de productos senior en Datarobot, centrado en productos AutomL y sequence temporales. Se ha centrado en traer avances en la ciencia de datos a los usuarios de manera que puedan aprovechar este valor para resolver los problemas comerciales del mundo actual. Tiene un título en matemáticas de la Universidad de California, Berkeley.