Estamos entusiasmados de compartir los primeros modelos en el rebaño Llama 4 están disponibles hoy en Azure Ai Foundry y Azure Databricks, que permite a las personas construir experiencias multimodales más personalizadas. Estos modelos de Meta están diseñados para integrar a la perfección los tokens de texto y visión en una columna vertebral de modelo unificado. Este enfoque innovador permite a los desarrolladores aprovechar los modelos LLAMA 4 en aplicaciones que exigen grandes cantidades de datos de texto, imagen y video no etiquetados, estableciendo un nuevo precedente en el desarrollo de IA.

Estamos entusiasmados de compartir los primeros modelos en el rebaño de Llama 4 están disponibles hoy en Azure ai fundición y Azure Databricksque permite a las personas construir experiencias multimodales más personalizadas. Estos modelos de Meta están diseñados para integrar a la perfección los tokens de texto y visión en una columna vertebral de modelo unificado. Este enfoque innovador permite a los desarrolladores aprovechar los modelos LLAMA 4 en aplicaciones que exigen grandes cantidades de datos de texto, imagen y video no etiquetados, estableciendo un nuevo precedente en el desarrollo de IA.

Hoy, estamos trayendo modelos de Scout y Maverick de Meta’s Llama 4 a Azure Ai Foundry como ofertas de cómputo administrados:

- Llama 4 Scout Fashions

- Llama-4-Scout-17b-16E

- Llama-4-Scout-17b-16E-Instructo

- Llama 4 Modelos Maverick

- Llama 4-Maverick-17B-128E-Instructo-FP8

Azure AI Foundry está diseñado para casos de uso de múltiples agentes, lo que permite una colaboración perfecta entre diferentes agentes de IA. Esto abre nuevas fronteras en aplicaciones de IA, desde la resolución de problemas complejas hasta la gestión de tareas dinámicas. Think about un equipo de agentes de IA que trabajan juntos para analizar grandes conjuntos de datos, generar contenido creativo y proporcionar información en tiempo actual en múltiples dominios. Las posibilidades son infinitas.

Para acomodar una variedad de casos de uso y necesidades de desarrollador, los modelos LLAMA 4 vienen en opciones cada vez más grandes. Estos modelos integran mitigaciones en cada capa de desarrollo, desde la capacitación previa hasta el post-entrenamiento. Las mitigaciones de nivel de sistema sintonizables protegen a los desarrolladores de usuarios adversos, capacitándolos para crear experiencias útiles, seguras y adaptables para sus aplicaciones respaldadas por LLAMA.

Llama 4 Scout Fashions: Energy and Precision

Estamos compartiendo los primeros modelos en el rebaño Llama 4, que permitirá a las personas construir experiencias multimodales más personalizadas. Según Meta, Llama 4 Scout es uno de los mejores modelos multimodales de su clase y es más poderoso que los modelos Llama 3 de Meta, mientras se ajustan en una sola GPU H100. Y LLAMA4 Scout aumenta la duración del contexto suitable de 128K en LLAMA 3 a ten millones de tokens líderes en la industria. Esto abre un mundo de posibilidades, incluida la resumen de documentos múltiples, analizando una amplia actividad del usuario para tareas personalizadas y razonamiento sobre vastas bases de código.

Los casos de uso dirigido incluyen resumen, personalización y razonamiento. Gracias a su largo contexto y tamaño eficiente, Llama 4 Scout brilla en tareas que requieren condensación o análisis de información extensa. Puede generar resúmenes o informes de entradas extremadamente largas, personalizar sus respuestas utilizando datos detallados específicos del usuario (sin olvidar detalles anteriores) y realizar un razonamiento complejo en grandes conjuntos de conocimientos.

Por ejemplo, Scout podría analizar todos los documentos en una biblioteca empresarial de SharePoint para responder una consulta específica o leer un handbook técnico de miles de páginas para proporcionar asesoramiento de problemas. Está diseñado para ser un “Scout” diligente que atraviesa una gran información y devuelve los aspectos más destacados o respuestas que necesita.

Llama 4 Modelos Maverick: Innovación a escala

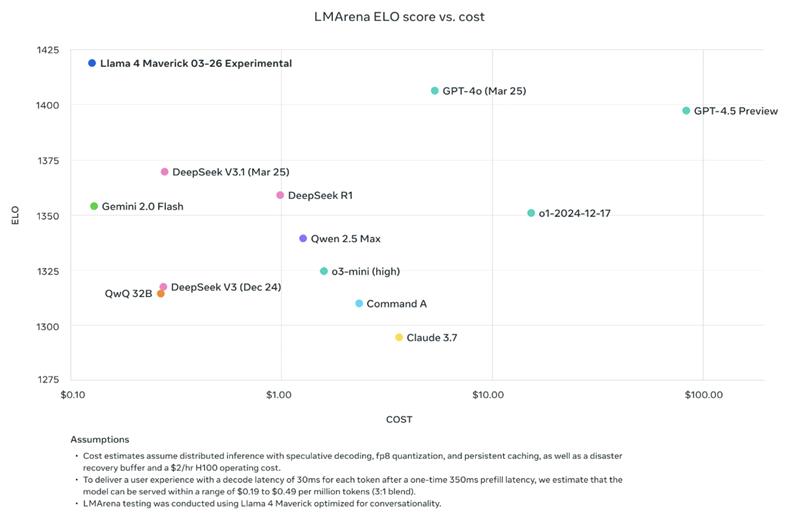

Como LLM de propósito basic, Llama 4 Maverick contiene 17 mil millones de parámetros activos, 128 expertos y 400 mil millones de parámetros totales, ofreciendo alta calidad a un precio más bajo en comparación con LLAMA 3.3 70B. Maverick sobresale en la comprensión de la imagen y el texto con soporte para 12 idiomas, lo que permite la creación de aplicaciones de IA sofisticadas que unen las barreras del idioma. Maverick es very best para la comprensión precisa de las imágenes y la escritura creativa, lo que lo hace bien adecuado para los casos de uso basic de asistentes y chat. Para los desarrolladores, ofrece inteligencia de última generación con alta velocidad, optimizada para la mejor calidad y tono de respuesta.

Los casos de uso dirigidos incluyen escenarios de chat optimizados que requieren respuestas de alta calidad. Meta Maverick Maverick para ser un excelente agente de conversación. Es el modelo de chat insignia de la familia Meta Llama 4, piense en él como la contraparte multilingüe multimodal de un asistente de chatgpt.

Es particularmente adecuado para aplicaciones interactivas:

- Bots de atención al cliente que necesitan comprender las imágenes que los usuarios cargan.

- AI Socios creativos que pueden discutir y generar contenido en varios idiomas.

- Asistentes empresariales internos que pueden ayudar a los empleados respondiendo preguntas y manejando aportes de medios ricos.

Con Maverick, las empresas pueden construir asistentes de IA de alta calidad que conversan naturalmente (y cortésmente) con una base de usuarios world y aprovechar el contexto visible cuando sea necesario.

Architectural Improvements in Llama 4: Multimodal fusión temprana y MOE

Según Meta, dos innovaciones clave aparecen a Llama 4: soporte multimodal nativo con fusión temprana y una mezcla escasa de diseño de expertos (MOE) para eficiencia y escala.

- Transformador multimodal de fusión temprana: Llama 4 utiliza un enfoque de fusión temprana, tratando el texto, las imágenes y los marcos de video como una secuencia única de tokens desde el principio. Esto permite que el modelo comprenda y genere varios medios juntos. Se destaca en tareas que involucran múltiples modalidades, como analizar documentos con diagramas o responder preguntas sobre la transcripción y las imágenes de un video. Para las empresas, esto permite a los asistentes de IA procesar informes completos (texto + gráficos + fragmentos de video) y proporcionar resúmenes o respuestas integradas.

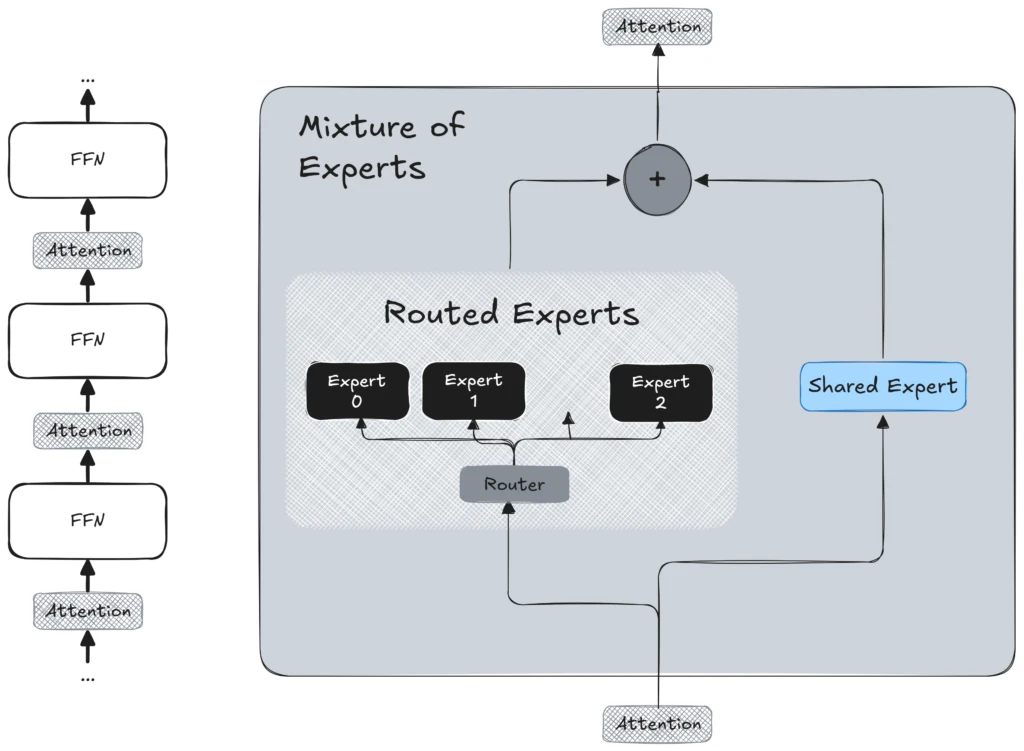

- Mezcla de vanguardia de la arquitectura de expertos (MOE): Para lograr un buen rendimiento sin incurrir en gastos de computación prohibitivos, Llama 4 utiliza una mezcla escasa de arquitectura de expertos (MOE). Esencialmente, esto significa que el modelo comprende numerosos submodelos de expertos, denominados “expertos”, con solo un pequeño subconjunto activo para cualquier token de entrada dado. Este diseño no solo mejora la eficiencia del entrenamiento, sino que también mejora la escalabilidad de la inferencia. En consecuencia, el modelo puede manejar más consultas simultáneamente distribuyendo la carga computacional en varios expertos, permitiendo la implementación en entornos de producción sin necesitar grandes GPU de una sola instancia. La Arquitectura MoE permite a LLAMA 4 expandir su capacidad sin aumentar los costos, ofreciendo una ventaja significativa para las implementaciones empresariales.

Compromiso con la seguridad y las mejores prácticas

Meta Constructed Llama 4 con las mejores prácticas descritas en su Guía de uso del desarrollador: protecciones de IA. Esto incluye la integración de mitigaciones en cada capa de desarrollo del modelo desde la capacitación previa hasta las mitigaciones de nivel posterior a la capacitación y sintonizables que protegen a los desarrolladores de los ataques adversos. Y, al hacer que estos modelos estén disponibles en Azure Ai Foundry, vienen con comprobados que los desarrolladores de barandas de seguridad esperan de Azure.

Empoderamos a los desarrolladores para crear experiencias útiles, seguras y adaptables para sus aplicaciones respaldadas por LLAMA. Discover los modelos Llama 4 ahora en el Azure AI Catálogo de modelos de fundición y en Azure Databricks Y comience a construir con lo último en IA multimodal con motor MOE, respaldada por la investigación de Meta y la fuerza de la plataforma de Azure.

La disponibilidad de metalama 4 en Azure ai fundición y Azure Databricks Ofrece a los clientes una flexibilidad incomparable para elegir la plataforma que mejor se adapte a sus necesidades. Esta integración perfecta permite a los usuarios aprovechar las capacidades avanzadas de IA, mejorando sus aplicaciones con soluciones potentes, seguras y adaptables. Estamos emocionados de ver lo que construye a continuación.