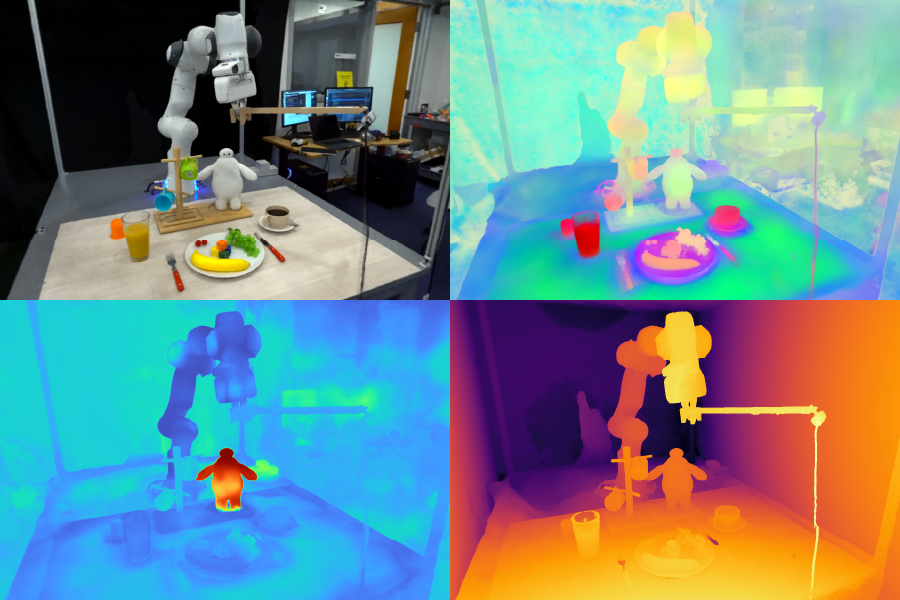

Los campos de funciones para manipulación robótica (F3RM) permiten a los robots interpretar indicaciones de texto abiertas utilizando lenguaje pure, lo que ayuda a las máquinas a manipular objetos desconocidos. Los campos de funciones 3D del sistema podrían resultar útiles en entornos que contienen miles de objetos, como almacenes. Imágenes cortesía de los investigadores.

Por Alex Shipps | MIT CSAIL

Imagina que estás visitando a un amigo en el extranjero y miras dentro de su refrigerador para ver qué sería un excelente desayuno. Muchos de los artículos inicialmente le parecen extraños, cada uno de ellos encerrado en envases y contenedores desconocidos. A pesar de estas distinciones visuales, comienzas a comprender para qué se utiliza cada uno y a elegirlos según sea necesario.

Inspirándose en la capacidad de los humanos para manejar objetos desconocidos, un grupo del Laboratorio de Ciencias de la Computación e Inteligencia Synthetic (CSAIL) del MIT diseñó campos de características para la manipulación robótica (F3RM), un sistema que combina imágenes 2D con características del modelo básico en escenas 3D para ayudar a los robots a identificar y agarrar elementos cercanos. F3RM puede interpretar indicaciones de lenguaje abierto de humanos, lo que hace que el método sea útil en entornos del mundo actual que contienen miles de objetos, como almacenes y hogares.

F3RM ofrece a los robots la capacidad de interpretar indicaciones de texto abierto utilizando lenguaje pure, ayudando a las máquinas a manipular objetos. Como resultado, las máquinas pueden comprender solicitudes menos específicas de los humanos y aun así completar la tarea deseada. Por ejemplo, si un usuario le pide al robotic que “coja una taza alta”, el robotic puede localizar y agarrar el artículo que mejor se ajuste a esa descripción.

“Hacer robots que realmente puedan generalizarse en el mundo actual es increíblemente difícil”, cube Ge Yangpostdoctorado en el Instituto de Inteligencia Synthetic e Interacciones Fundamentales de la Fundación Nacional de Ciencias y MIT CSAIL. “Realmente queremos descubrir cómo hacerlo, así que con este proyecto intentamos impulsar un nivel agresivo de generalización, desde sólo tres o cuatro objetos hasta cualquier cosa que encontremos en el Stata Middle del MIT. Queríamos aprender a hacer robots tan flexibles como nosotros, ya que podemos agarrar y colocar objetos aunque nunca los hayamos visto antes”.

Aprender “qué hay y dónde mirando”

El método podría ayudar a los robots a recoger artículos en grandes centros logísticos con un desorden e imprevisibilidad inevitables. En estos almacenes, los robots suelen recibir una descripción del inventario que deben identificar. Los robots deben hacer coincidir el texto proporcionado con un objeto, independientemente de las variaciones en el embalaje, para que los pedidos de los clientes se envíen correctamente.

Por ejemplo, los centros logísticos de los principales minoristas en línea pueden contener millones de artículos, muchos de los cuales nunca antes habría encontrado un robotic. Para operar a tal escala, los robots necesitan comprender la geometría y la semántica de diferentes elementos, algunos de los cuales se encuentran en espacios reducidos. Con las capacidades avanzadas de percepción espacial y semántica de F3RM, un robotic podría volverse más eficaz a la hora de localizar un objeto, colocarlo en un contenedor y luego enviarlo para empaquetarlo. En última instancia, esto ayudaría a los trabajadores de las fábricas a enviar los pedidos de los clientes de manera más eficiente.

“Una cosa que a menudo sorprende a la gente con F3RM es que el mismo sistema también funciona a escala de habitación y edificio, y puede usarse para construir entornos de simulación para el aprendizaje de robots y mapas grandes”, cube Yang. “Pero antes de ampliar aún más este trabajo, primero queremos que este sistema funcione realmente rápido. De esta manera, podemos utilizar este tipo de representación para tareas de management robótico más dinámicas, con suerte en tiempo actual, de modo que los robots que manejan tareas más dinámicas puedan utilizarla para la percepción”.

El equipo del MIT señala que la capacidad del F3RM para comprender diferentes escenas podría hacerlo útil en entornos urbanos y domésticos. Por ejemplo, este enfoque podría ayudar a robots personalizados a identificar y recoger artículos específicos. El sistema ayuda a los robots a captar su entorno, tanto física como perceptivamente.

“David Marr definió la percepción visible como el problema de saber ‘qué hay y dónde mirando'”, cube el autor principal. Phillip Isolaprofesor asociado de ingeniería eléctrica e informática del MIT e investigador principal de CSAIL. “Los modelos de fundaciones recientes se han vuelto realmente buenos al saber lo que están mirando; pueden reconocer miles de categorías de objetos y proporcionar descripciones textuales detalladas de imágenes. Al mismo tiempo, los campos radiantes se han vuelto muy buenos para representar dónde están las cosas en una escena. La combinación de estos dos enfoques puede crear una representación de qué es dónde en 3D, y lo que nuestro trabajo muestra es que esta combinación es especialmente útil para tareas robóticas, que requieren manipular objetos en 3D”.

Creando un “gemelo digital”

F3RM comienza a comprender su entorno tomando fotografías con un palo para selfies. La cámara montada toma 50 imágenes en diferentes poses, lo que le permite construir una campo de radiación neuronal (NeRF), un método de aprendizaje profundo que toma imágenes 2D para construir una escena 3D. Este collage de fotografías RGB crea un “gemelo digital” de su entorno en forma de una representación de 360 grados de lo que hay cerca.

Además de un campo de radiación neuronal muy detallado, F3RM también crea un campo de características para aumentar la geometría con información semántica. El sistema utiliza ACORTARun modelo básico de visión entrenado en cientos de millones de imágenes para aprender conceptos visuales de manera eficiente. Al reconstruir las características CLIP 2D de las imágenes tomadas con el palo para selfies, F3RM eleva efectivamente las características 2D a una representación 3D.

Mantener las cosas abiertas

Después de recibir algunas demostraciones, el robotic aplica lo que sabe sobre geometría y semántica para agarrar objetos que nunca antes había encontrado. Una vez que un usuario envía una consulta de texto, el robotic busca en el espacio de posibles agarres para identificar aquellos con más probabilidades de lograr recoger el objeto solicitado por el usuario. Cada opción potencial se califica según su relevancia para el mensaje, la similitud con las demostraciones en las que se entrenó al robotic y si causa alguna colisión. Luego se elige y ejecuta el agarre con la puntuación más alta.

Para demostrar la capacidad del sistema para interpretar solicitudes abiertas de humanos, los investigadores solicitaron al robotic que recogiera a Baymax, un personaje de “Large Hero 6” de Disney. Si bien F3RM nunca había sido entrenado directamente para recoger un juguete del superhéroe de dibujos animados, el robotic utilizó su conciencia espacial y sus características de visión y lenguaje de los modelos básicos para decidir qué objeto agarrar y cómo recogerlo.

F3RM también permite a los usuarios especificar qué objeto quieren que maneje el robotic en diferentes niveles de detalle lingüístico. Por ejemplo, si hay una taza de metallic y una taza de vidrio, el usuario puede pedirle al robotic la “taza de vidrio”. Si el robotic ve dos tazas de cristal y una de ellas está llena de café y la otra de zumo, el usuario puede pedir la “taza de cristal con café”. Las características del modelo básico integradas en el campo de características permiten este nivel de comprensión abierta.

“Si le mostrara a una persona cómo tomar una taza por el borde, fácilmente podría transferir ese conocimiento para tomar objetos con geometrías similares, como tazones, vasos medidores o incluso rollos de cinta adhesiva. Para los robots, lograr este nivel de adaptabilidad ha sido todo un desafío”, cube el estudiante de doctorado del MIT, afiliado a CSAIL y coautor principal. William Shen. “F3RM combina la comprensión geométrica con la semántica de modelos básicos entrenados con datos a escala de Web para permitir este nivel de generalización agresiva a partir de solo una pequeña cantidad de demostraciones”.

Shen y Yang escribieron el artículo bajo la supervisión de Isola, con la profesora del MIT e investigadora principal de CSAIL Leslie Pack Kaelbling y los estudiantes universitarios Alan Yu y Jansen Wong como coautores. El equipo contó con el apoyo, en parte, de Amazon.com Providers, la Fundación Nacional de Ciencias, la Oficina de Investigación Científica de la Fuerza Aérea, la Iniciativa Universitaria Multidisciplinaria de la Oficina de Investigación Naval, la Oficina de Investigación del Ejército, el Laboratorio Watson del MIT-IBM y el MIT en busca de inteligencia. Su trabajo se presentará en la Conferencia sobre Aprendizaje de Robots de 2023.

Noticias del MIT