Boston Dynamics publicó un nuevo video que destacaba cómo su nuevo humanoide de Atlas Electrical realiza tareas en el laboratorio. Puedes ver el video de arriba.

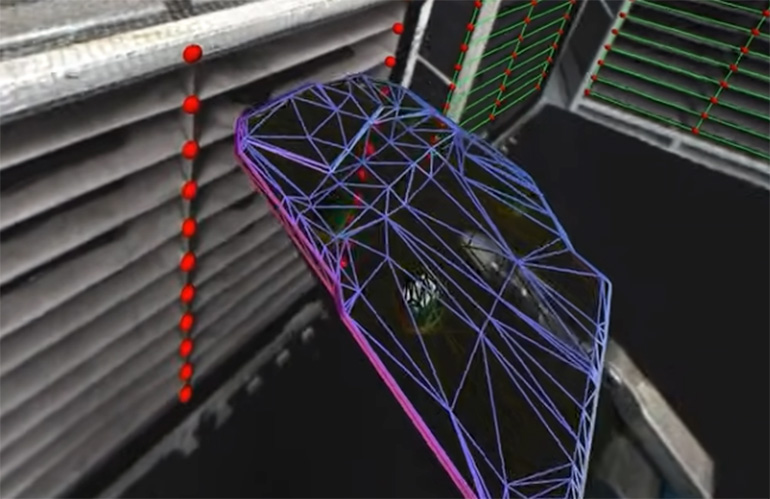

Lo primero que me golpea del video es cómo Atlas muestra su percepción en tiempo actual. El video muestra cómo Atlas registra activamente su marco de referencia para las cubiertas del motor y todas las ubicaciones de selección/lugar. El robotic actualiza continuamente su comprensión del mundo para manejar las piezas de manera efectiva. Cuando recoge algo, evalúa la topología de la pieza: cómo manejarlo y dónde colocarlo.

Atlas percibe la topología de la parte que se mantiene en su mano mientras adquiere la parte del estante. | Crédito: Boston Dynamics

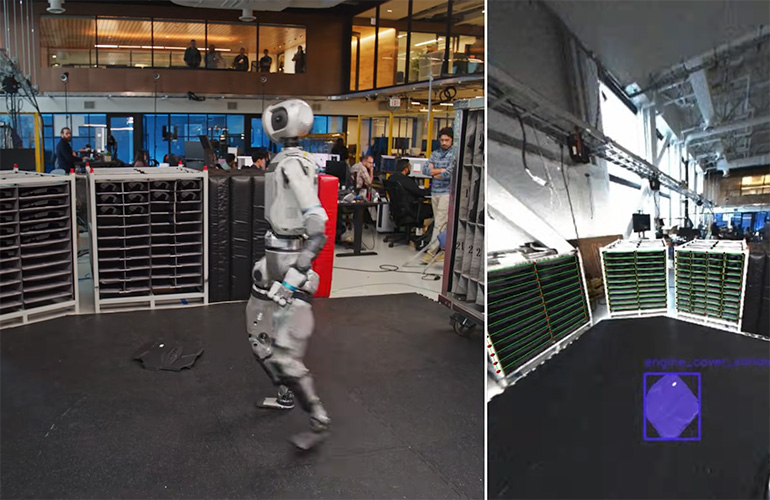

Luego, hay este momento a las 1:14 en la demostración donde un ingeniero dejó caer una cubierta del motor en el piso. Atlas reacciona como si escuchara la parte golpeando el piso. El humanoide luego mira a su alrededor, localiza la pieza, descubre cómo recogerla (nuevamente, evaluando su forma) y lo coloca con la precisión necesaria en el área de cubierta del motor.

“En este clip en explicit, el comportamiento de búsqueda se activa manualmente”, dijo Scott Kuindersma, director senior de investigación de robótica en Boston Dynamics “, dijo El informe del robotic. “El robotic no está utilizando señales de audio para detectar una cubierta del motor que golpea el suelo. El robotic está” encontrando “el objeto en el piso, por lo que en la práctica podemos ejecutar el mismo modelo de visión pasivamente y activar el mismo comportamiento si una cubierta del motor (o cualquier parte que estamos trabajando) se detecta de la acteza durante la operación regular”.

El video destaca la capacidad de Atlas para adaptarse y percibir su entorno, ajustar su concepto de ese mundo y aún así seguir su tarea asignada. Muestra cómo Atlas puede manejar entornos caóticos, mantener su objetivo de tarea y hacer cambios en su misión sobre la marcha.

Atlas puede escanear el piso e identificar una parte en el piso que no pertenece allí. | Crédito: Boston Dynamics

“Cuando el objeto está en vista de las cámaras, Atlas usa un modelo de estimación de pose de objeto que utiliza un enfoque de render y comparación para estimar la pose de las imágenes monoculares”, escribió Boston Dynamics en un weblog sobre el video. “El modelo está entrenado con datos sintéticos a gran escala y generaliza a los objetos novedosos a un modelo CAD. Cuando se inicializa con una pose 3D anterior, el modelo lo refina iterativamente para minimizar la discrepancia entre el modelo CAD renderizado y la imagen de la cámara capturada. se alimentan a un modelo de puntuación, y la mejor hipótesis de ajuste se refina posteriormente.

Ya veo, por eso soy

La guía de la visión del robotic ha sido viable desde la década de 1990. En ese momento, los robots podrían rastrear elementos en transportadores móviles y ajustar los marcos de referencia locales para un conjunto de placa de circuito basado en fiduciales. Nada es sorprendente o novedoso sobre este estado del arte para la guía de la visión de robots.

Lo que es único ahora para los humanoides es la movilidad del robotic. Cualquier manipulador móvil debe actualizar constantemente su mapa mundial. Fashionable Robotic Imaginative and prescient Steering utiliza modelos de lenguaje de visión (VLM) para comprender el mundo a través del ojo de la cámara.

Esos robots industriales más antiguos se fijaron en el suelo y usaron visión 2D y rutinas de calibración complejas para mapear el campo de visión de la cámara. Lo que estamos viendo demostrado con Atlas es un robotic móvil y humanoide que comprende su entorno y continúa su tarea, incluso cuando el entorno cambia alrededor del robotic. Los robots modernos tienen una comprensión 3D del mundo que los rodea.

Boston Dynamics admite que esta demostración es una mezcla de funciones basadas en IA (como la percepción) y alguna programación de procedimientos para administrar la misión. El video es una buena demostración de la progresión de las capacidades de la evolución del software program. Para que estos sistemas funcionen en el mundo actual, deben manejar cambios sutiles y cambios macro en sus entornos operativos.

Abriéndose paso en el mundo

Es fascinante ver a Atlas moverse. Los movimientos, a veces, parecen un poco extraños, pero es una excelente ilustración de cómo la IA percibe el mundo y las elecciones que hace para moverse por el mundo. Solo podemos presenciar una pequeña porción de esta toma de decisiones en el video.

Dinámica de Boston previamente ha publicado un video que muestra comportamientos basados en captura de movimiento (MOCAP). El video MOCAP demuestra la agilidad del sistema y lo que puede hacer con la entrada suave. La sacudida de este último video, bajo la toma de decisiones y el management de la IA, está muy lejos de las manifestantes manifestaciones de MOCAP que involucran el valle. También presentamos Boston Dynamics CTO Aaron Saunders como presentador principal al 2025 Cumbre y Expo de Robótica en Boston.

Queda mucho procesamiento en tiempo actual para que Atlas comprenda su mundo. En el video, vemos que el robotic se detiene para procesar el entorno, antes de que tome una decisión y continúe. Estoy seguro de que esto solo será más rápido con el tiempo a medida que evolucione el código y los modelos de IA mejoran en su comprensión y adaptabilidad. Creo que ahí es donde está la carrera ahora: desarrollar el software program basado en IA que permite que estos robots se adapten, comprendan su entorno y aprendan continuamente de una variedad de datos multimodales.

Nota del editor: Este artículo se actualizó a la 1:46 pm Jap con una cita de Scott Kuindersma, Director Senior de Investigación de Robótica en Boston Dynamics.